ペンタックスK-3がローパスセレクターなる機能を搭載して登場したことに驚いている。ローパスフィルター(以下、LPF)の有無を切り替え? そんなことが可能なのか? と最初は怪訝に思ったが、なんとボディー内手ぶれ補正機構(SR)を利用してわざと微小なブレを発生させてやることにより、LPFと同等の効果を生み出す仕組みらしい。これぞまさに逆転の発想であり、ペンタックスはすごいと思った。今まで誰も考えつかなかったコロンブスの卵的発想ではないか!

よく考えてみると、ペンタックスはこのSRを本来の手ぶれ補正以外にいろんな機能に応用している。たとえば構図微調整機能とか、傾き補正機能がそれである。その他オプションでは自動的に星の日周運動を追尾するアストロトレーサーにも使っているし、エントリー機ではなんとセンサーのダストリダクションにまで応用している(効果はほとんどないらしいが)。ペンタックスは本当にSRがお好きなのだなと感心する。(笑)

これによりLPFの有無で2機種を出す必要がなくなったのは画期的だろう。レンズ交換式カメラでローパスフィルターレスが最初に話題になったのはLeica M9だったと記憶しているが、その後ニコンD800Eでローパスフィルターレスによる超高解像度が大々的に宣伝され、一気にトレンドになった感がある。最近ではペンタックスK-5IIsやニコンD7100もローパスフィルターレスで出てきた。その際D7100は別として、D800EやK-5IIsには通常のLPF有りモデルも用意されている。メーカーの思惑としては、LPF有りモデルは一般ユーザー向け、LPF無しモデルはより解像感を求めるハイエンドユーザー向けという位置づけをしているようだ。しかし実際にはLPF無しモデルばかりが売れて、LPF有りモデルはまったく人気がないのが実状。そりゃそうだろう、LPFは画像をモヤモヤさせる悪役のように言われているから、誰だってクッキリハッキリ写る方を欲しがるに決まっている。LPF有りモデルは商品撮影などモアレが発生しては絶対困るような一部のプロユーザーにしかニーズがないと思われる。それじゃ完全にメーカーの読み違いだったということになるのか? 決してそんなことはないと思っている。

LPFというのは水晶などが使われているらしく、デジタルカメラを構成する部品の中ではかなり高価な部類に入る。したがって、LPFを省略すれば本来ならコストダウンになるはずなのだ。しかし実際にはLPF無しモデルの方が高価格になっている。D800EはD800より5万円近くも高いし、K-5IIsでもK-5IIより1万円ほど高い。正確に言うとD800EはLPFを省略したのではなくて、その効果を打ち消すようなフィルターが入っているらしいから若干コストアップになることは考えられる。それにしても5万円は大きすぎるんじゃないか? K-5IIsに至っては完全にLPFを省略したわけだから、確実にコストダウンになるはずだ。これってどう考えてもおかしい。メーカーの言い分としては、LPF無しモデルは生産量が少ないので製造コストが高くなると説明しているが、実際にはLPF無しモデルばかりが売れているのだから、それは明らかに矛盾している。決してそれが理由ではないと思っている。そこにはメーカーのしたたかな戦略が見えてくる。

実際には、メーカーはLPF無しモデルがユーザーに好まれることを予見していたと考えられる。そこでLPF無しのありがたみを強調して付加価値を高め、価格を吊り上げることを狙ったのだろう。しかもちゃっかりコストダウンまでして利益はさらに拡大するからメーカーにとっては一挙両得だ。最近はデジタルカメラの技術革新も飽和に近づいており、価格競争もいっそう激しくなっている。そこでメーカーは簡単に解像力を上げられるローパスフィルターレスに着目し、付加価値の向上と価格の吊り上げ、そしてコストダウンを同時に達成することに成功した。ローパスフィルターレスはメーカーにとっては一粒で二度も三度も美味しい新機軸だったのだ。

LPF無しモデルばっかりが売れちゃったのは決して結果論ではなく、初めから仕組まれていたこと。さすがにそれが明らかになっちゃうとメーカーもこれ以上同じ手口は使えないと気づいたのだろう、最近はLPF無しモデルしか出さなくなってきた。市場のニーズが明らかになった以上、もう誤魔化すことはできない。今後、ハイエンドモデルはすべてLPF無しになっていくことは間違いないだろう。それは歓迎すべきことではあるが、一方でモアレに対する懸念が消えたわけじゃない。ごく稀な条件でしか発生しないとはいえ、LPF無しモデルが標準になったらカメラ側で対処することができなくなる。オリンパスのファインディテール処理のように、解像感を保ちながらソフト的にモアレを軽減することも可能ではあるが、ソフトによる処理は必ず何らかの弊害を伴う。もしかすると例のモヤモヤ現象もファインディテール処理が悪さをしている可能性もある。したがって、できるだけ物理的な手段で解決することが望ましい。ではLPFのないカメラでモアレを軽減するにはどうすればよいのかについて考えよう。そのためにはLPFの原理と必要性について深く理解していることが求められる。本来こういう難しいことを説明するには図解を用いて視覚的に表現することが不可欠だが、とてもそこまでやってる暇がないので文章だけにとどめておく。文章だけで説明することは大変難しいが、そこは想像力を働かせて理解していただきたい。

LPFというのは、もともとは電気の分野で用いられてきた用語である。基本的にはある周波数より低い交流信号のみ通過させ、それ以上高い周波数の交流信号をカットする働きを持つ。その境界となる周波数のことをカットオフ周波数と呼ぶ。デジタルカメラの登場に先駆けて、デジタル録音の分野ではすでに一般化しており、知らず知らずのうちにそのお世話になっていたのである。デジタル録音というのは音の波形を電圧に置き換え、さらにそれを数値化したものである。もっと具体的に言えば、1秒間を何万回という細かい単位に分割し、その瞬間瞬間の電圧値を数値に置き換える。これがA/D変換だ。そのとき1秒間あたりの分割数のことをサンプリング周波数と呼ぶ。現在一般的に使われているCDの規格では、44100Hzというサンプリング周波数が用いられている。つまり、1秒間あたり44100個の数値で置き換えるということに相当する。ここでなぜ44100Hzという値が用いられているのかということだが、サンプリング定理というものがあって、デジタル信号として表現可能な最大周波数はサンプリング周波数の1/2であるという性質がある。この周波数のことをナイキスト周波数と呼び、サンプリング周波数が44100Hzであればナイキスト周波数は22050Hzとなる。これは言い換えれば、CDに記録できる音の周波数は最大22050Hzまでということになる。人間の耳に聞こえる音の周波数はおよそ20000Hzまでと言われているから、それで実用上問題ないと考えられ、そのように決まったわけだ。ここでもしマイクで拾った音に22050Hz以上の成分が含まれていたらどうなるか? それはもはやナイキスト周波数を超えているからデジタル信号としては再現することができず、本来は存在しないノイズとして混入されてしまう。これをエイリアスノイズと呼んでいるが、それを避けるためには22050Hz以上の音をカットしてやる必要が出てくる。そこで実際のデジタル録音では、A/D変換を行う前にアナログのローパスフィルターを挿入して高周波成分をカットすることにより、エイリアスノイズの発生を抑えている。このことからローパスフィルターは海外ではアンチエイリアス(AA)フィルターと呼ばれることが多い。

こんな端折った説明で理解するのはまず不可能だろう。余計混乱させただけかもしれない。しかし原理はデジタル録音もデジタルカメラも全く同じだということを言いたかったのだ。つまりアナログ信号をデジタル信号に変換する時点で、必ずナイキスト周波数という限界が出てきてしまうのだ。それを超えてしまうと本来は存在しない「お化け」信号が発生してしまう、そのように理解していただきたい。これはすべてのデジタル機器が共通して持っている宿命である。デジタルカメラの場合、その「お化け」信号のことを「モアレ」と呼んでいるわけだ。

では、デジタルカメラにおけるナイキスト周波数とは何なのだろうか? 音に周波数があるのはわかるが、画像の周波数と言われてもピンと来ないだろう。しかしそれは画像の「細かさ」と考えれば理解できる。最も単純な画像として、黒白黒白・・が連続する横縞模様を考えよう。これをデジタルカメラで画面いっぱいに撮影したとする。デジタルカメラの撮像素子は正方形の画素が格子状に規則正しく配列していることは誰もが知っているだろう。すると撮像素子が黒白のパターンを解像できる限界は、ちょうど黒白の間隔が撮像素子の画素ピッチとピッタリ一致する場合であることは容易に理解できるだろう。つまり撮像素子の上では、上から順に黒白黒白・・が交互に繰り返されている状態だ。もしこれ以上黒白の間隔を細かくしたとすると、黒が連続するところや白が連続するところ、あるいは黒と白が混じってグレーになってしまうところができて、元のパターンとは異なる絵になってしまうことは想像できるだろう。つまりこれ以上細かいパターンを解像することは不可能で、これが撮像素子のナイキスト周波数となる。ここで言う周波数とは単位長さあたりに含まれる線の本数のことであり、空間周波数と呼ばれる。そしてナイキスト周波数を超える細かいパターンが結像されると本来は存在しない模様となって現れ、それがモアレの正体である。

空間周波数は一般にlw/ph(line width per height)という単位で表されることが多い。つまり画面の高さあたり何本の線を解像できるかという指標である。撮像素子の場合、これは画素数で決まる。たとえばK-5IIsの場合は短辺方向の画素数が3264ピクセルだから、黒白の横線を解像できる限界はちょうどその半分の1632本、つまりナイキスト周波数は1632lw/phということになる。ここでも音と同じようにサンプリング定理が成り立っていることがわかるだろう。ここで言うサンプリング周波数は短辺方向の画素数そのものだから、ナイキスト周波数はちょうどその1/2になるのだ。

撮像素子と同じく、レンズにも解像度というものがあり、便宜的に同じlw/phという単位で表される。絶対的な指標としては「本/ミリ」という単位も使われるが、それでは画面サイズによって実質的な解像力が変わってしまうため、異なるサイズで比較するには都合が悪い。そこでデジタルカメラではlw/phという相対単位を使うことにより、画面サイズの違いを気にしなくて済むようにしたのである。ここまで書くと賢明な人はもう気づいたと思うが、モアレが発生するか否かはレンズの解像度と撮像素子の解像度との兼ね合いで決まるのである。すなわち、レンズの解像度が撮像素子のナイキスト周波数を上回った場合にモアレが発生する可能性があり、その逆であれば原理的にモアレは発生しない。一般的なレンズの解像度がどのくらいかというと、優秀なレンズでは上限2500lw/ph程度、並のレンズでは上限2000lw/ph程度、そして糞レンズでは1500lw/ph以下といった具合である。するとK-5IIsの場合、ナイキスト周波数が1632lw/phだから、並以上のレンズであればモアレが発生する可能性があるということになる。このことからモアレが発生しにくくするには、画素数を増やすか、糞レンズを使うか(笑)、どっちかであることも理解できるだろう。最近のD7100やK-3がLPF無しのモデルしか用意されていない理由は、2400万画素であることも大いに寄与している。このクラスならナイキスト周波数は2000lw/phとなり、大方のレンズでモアレはそれほど気にしなくていいことになるからだ。またコンデジでは1/2.3インチのような極小センサーに1600万画素以上を詰め込んでいるため、画素ピッチが極めて小さくなっており、完全にレンズの解像度の方が負けている。したがって、コンデジでは原理的にモアレは発生せず、かなり早い段階からLPFが省略されてきたのもそのためである。

以上でモアレが発生する条件についておおよそ飲み込めたと思うが、実際には解像度の高いレンズを使ったからといって必ずモアレが発生するわけではない。それはほとんど撮影する被写体に依存する。タイルの壁やトタンのような規則正しいパターンが連続する場合にはモアレが目立つ可能性があるが、自然風景のようにランダムで複雑な絵柄が背景にある場合には、たとえモアレが発生したとしても背景に紛れて人間の目には知覚できなくなる。だから自然風景ではLPF無し、人工風景ではLPF有りが良いと言われるのはそのためである。少なくとも自然風景でモアレを気にする必要はまったくないだろう。人工風景でもそうめったに発生するものではないし、後に述べる方法で回避することは可能である。

実はここまでの議論では一つ重要なことが抜けている。それは色の存在だ。つまり、上の議論では色についてはまったく考慮せず、モノクロだと仮定した場合の話である。しかし実際のデジタルカメラはフルカラーだから、話はもっと複雑になる。よく知られているように、デジタルカメラの撮像素子は光の強さしか感じることができず、色についてはまったく認識できない。そのままではモノクロの画像しか得られないのだ。そこでカラー画像を得るために、画素の一つ一つにカラーフィルターというものを装備し、RGBそれぞれの色に分解する方式をとっている。それがいわゆるベイヤー方式の画素配列である。

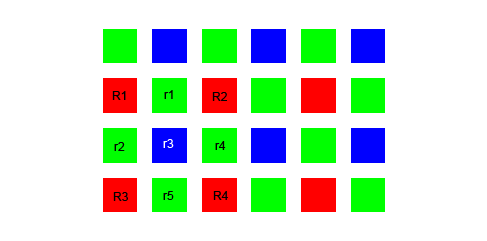

上の図のように、ベイヤー方式ではRGGBの画素が4画素を一組として規則正しく配列されている。ここでグリーンが2つあるのは、人間の目がグリーンに最も感じやすいという特性による。これで3原色が揃ったので原理的にはフルカラーが表現できるようになったのだが、ここに大きな問題がある。それは4画素を一組にしているため、すべての画素でフルカラーを表現できるわけではないということ。R画素はレッドだけしか感じることができないし、G画素はグリーンだけしか感じることはできない。しかし写真画像として成立するためには、すべての画素がRGBの情報を持っていなければならない。そこでどうするかというと、画素補間という方法を使うのだ。つまり該当する色のデータが存在しない画素では、隣接する画素からデータを「推定」することによって擬似的に画素データを作り出すのである。

その画素補間の方法はメーカーによって独自のノウハウがあり、それがメーカーの絵作りにもつながっているわけだが、最も単純化して考えると次のようになる。いまレッドを感じる画素が上の図のようにR1, R2, R3, R4と4つあったとして、それに隣接する画素r1, r2, r3, r4, r5におけるレッドのデータを推定したいとする。すると最も単純な補間では次のようにして求められる。

r1 = (R1 + R2) / 2

r2 = (R1 + R3) / 2

r3 = (R1 + R2 + R3 + R4) / 4

r4 = (R2 + R4) / 2

r5 = (R3 + R4) / 2

これを線形補間と呼んでいるが、要するに隣接する画素の値を平均するだけである。これで実際には存在しない画素であっても、「おおよその」値を推定することが可能になる。しかしこれが可能になるためには、ある条件を満たす必要がある。それは当該画素に当たった光が完全に一点に収束せず、ある程度周りに分散していることが絶対に必要なのだ。たとえば画素r3について注目してみよう。このr3のレッド値を推定するためには、周囲のR1, R2, R3, R4すべてのデータが必要になることが上の式からわかる。しかし、もしr3に当たった光が完全にそこで収束し、まったく周りに散らばらないとすれば、それは周囲の画素にまったく影響を与えないことになるから、R1, R2, R3, R4からr3のレッド値を推定することは不可能になる。周りの画素はr3とは完全に独立しており、r3に当たった光の情報がまったく届いていないのだから、そこからr3のデータを推定することは絶対に不可能であることは容易に理解できるだろう。この場合、r3とはまったく無関係なR1, R2, R3, R4のデータからレッド値が推定されたことになり、実際とは異なる色が作られてしまう。これが「偽色」と呼ばれる現象だ。したがって、周りの画素からr3のレッド値を推定するためには、r3に当たった光が少し周りに散らばることが必要ということになる。

この働きを担っているのがLPFというわけだ。LPFは水晶などが持つ複屈折性を利用して、一点に結ばれた像を周囲に分散させる働きをする。実際に見た人は少ないだろうが、透明な方解石の結晶を本の上に載せると文字が二重になって見えるというあれである。ベイヤー方式では4つの画素で一つの色を構成するため、一点に結ばれた像を均等に4画素分に分散させるようにチューニングされている。これは言い換えれば像をボカすことと等価であり、もちろんモアレの軽減にも役立っている。ベイヤー方式を採用する以上、LPFは原理的に必要なものであり、省略すると偽色の発生は避けられないように思える。しかし実際にはLPF無しのモデルでも偽色が問題になることはほとんどない。それは上の議論はあくまでも理想系であって、実際の物理現象はそんなに単純ではないからと考えられる。実際にはどんな優秀なレンズであっても収差が存在するから、光が完全に一点に収束することはなく、わずかながら周囲に分散すると考えられるし、RGBのカラーフィルターにしても完全にその色だけを通すというわけではなくて、それ以外の色も一定量通過してしまう。それらの影響が重なって、たとえLPFがなくても多少なりとも像は周囲の画素に分散しているはずだから、結果的にLPFと同じ働きをしていると推測される。その効果は高画素になるほど顕著になるため、APS-Cの2400万画素クラスではLPF無しでも人間の目の錯覚でほとんど問題のないレベルになっているのだろう。将来的に5000万画素超の時代が来れば、もはや撮像素子の解像度にレンズの解像度がついて行けなくなるから、原理的にLPFは不要の時代が来ると予測する。

なおモアレと偽色はまったく別の現象であり、本来は区別して考えるべきものだが、どちらもLPFが解決してくれるため、一緒に扱われることが多い気がする。上で述べたように、ベイヤー方式では4画素を一組にして画素補間を行っているため、色も含めた解像度は総画素数よりかなり低くなっていると考えなければならない。本来存在しない画素を補間によって作り出しているわけだから、情報理論的に言えば実際の画素数は1/3~1/4程度になるであろう。つまり2400万画素と言っても実際には800万画素程度の解像度しかないのだ。遠景の樹木などを撮るとどうしてもモヤモヤしてしまうのはそのせいである。したがって、色情報も含めたナイキスト周波数は短辺方向のピクセル数の半分よりかなり低くなっていると考えなければならない。そのためモノクロよりも早い段階でモアレが現れ、正確にはモアレと偽色が同時に発生している状況と理解すべきだろう。このことは覚えておいた方がいい。

さて、ここでやっとK-3の話になるのだが、今までLPFがやっていた光を分散させるという仕事を、撮像素子をわずかに動かすことによって人工的にブレを発生させ、LPFと同じ効果を生み出すということがすんなりと理解できるのではないだろうか。これは言われてみればなるほど!なのだが、そんなことを考えた人が今までいるだろうか? ペンタックスにはすごいアイディアマンがいるようだ。このローパスセレクターは撮像素子を1ピクセル以下の単位で、しかも露光中に動かすというから、まさにミクロン単位の精度を要求される高度な技術である。本当にそんなことが可能なのか?と思えるが、ペンタックスのことだから何かやらかしてくれるのではないかと、ちょっと期待もしている。(笑)

ここでもし、ボディー内手ぶれ補正機構を持たないニコンやキヤノンが同じことをするとすれば、どうするだろうか? おそらく一番簡単な方法は、AFの精度をわずかにずらすことだろう。わずかにボカしてレンズの解像度を下げてやれば、LPFと同じ効果が得られるはずだ。この方法なら新たなハードウェアは必要なく、ソフトウェアだけで実現できるので、コストもほとんどかからない。ただMFでは利用できないという問題は残る。そこで次に考えられるのは、撮像面をわずかに前後させてピント位置をずらすことだろう。これなら露光中に動かす必要もないので、K-3の方式より比較的簡単と言える。ただ機械的な誤差により、ピント精度の問題という弊害も出てきそうな気がする。そこまでしてニコンやキヤノンがやるだろうか? たぶんモアレは自分で解決しろと言いそうだから、やらないだろうなぁ・・(笑)

さて、やっと本題に入るが(笑)、K-3のようにモアレをカメラ側で抑制してくれればそれでいいのだが、LPF無しのモデルでモアレが発生してしまう場合、どうやって回避すればよいのだろうか? よく言われる方法は、「撮影距離を変える」「構図を変える」「絞りを変える」の3点である。

たとえばタイル壁のような規則的パターンを持つ被写体を撮った場合にモアレが発生しやすいのだが、必ずしも発生するわけではない。レンズが解像できないほど遠景であれば問題にならないし、逆にはっきりパターンが見えるほど近くであればこれも問題にならない。一番モアレが発生しやすい条件は、パターンの周期が撮像素子の解像限界に近い場合だろう。それより周期が長くても短くてもモアレは発生しにくい。つまりモアレが発生しやすい「共振周波数」みたいなものが存在するのだ。したがって、その周期を避けてやることによりモアレをほとんど消すことができる。具体的には撮影距離を変えるか、あるいはズーミングで焦点距離を変えることである。要するに像倍率を変えることにより、パターンの周期を少しずらしてやればいいということになる。また別の方法としては構図を変える、アングルを変えるということでもいい。それによって撮像面に投影される角度や大きさが変われば、やはりモアレが発生する条件を避けることができる。

ただ上の方法では、撮影時にモアレが発生しているかどうかを確認できないという問題がある。液晶画面で拡大して見ればその場で確認も可能だが、いちいちそんなことをやっているのは効率が悪いだろう。そこで一番確実な方法は、絞りを十分絞ることである。一般的にレンズは絞るほど回折の影響により解像度が低下する傾向がある。APS-Cならf16、フルサイズならf22まで絞ると確実に回折の影響が出てきて、解像力はかなり落ちる。つまり、これがLPFと同じ役割を果たすのだ。したがって、モアレが出そうだなと思ったら思いっきり絞ってやるだけでいい。解像度は若干犠牲になるが、これが一番確実な方法だ。

以上、モアレを軽減する方法は言ってしまえば非常に単純なのだが、それを本当に使いこなすためにはやはりLPFの原理について十分理解している必要があると思うのだ。だからこそ、ここまで長々と書いてきたわけである。